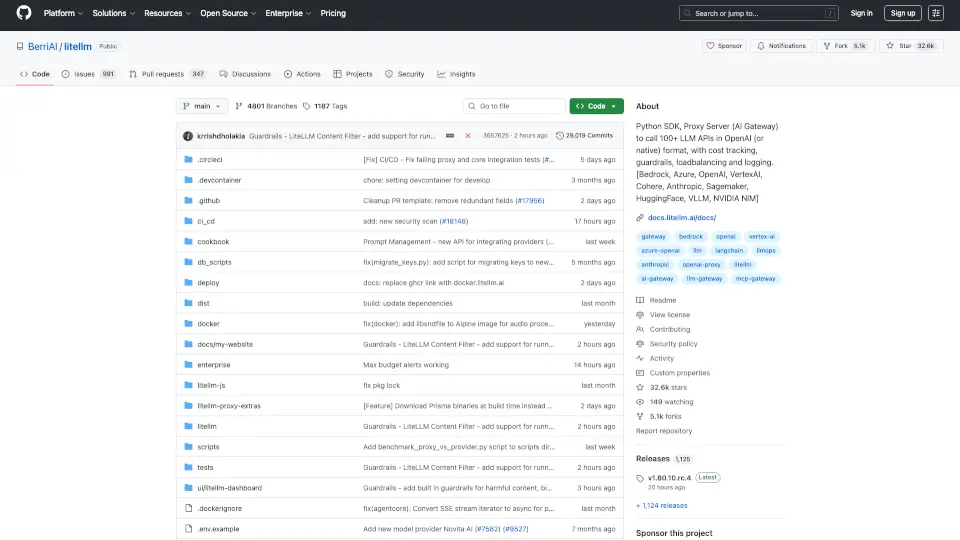

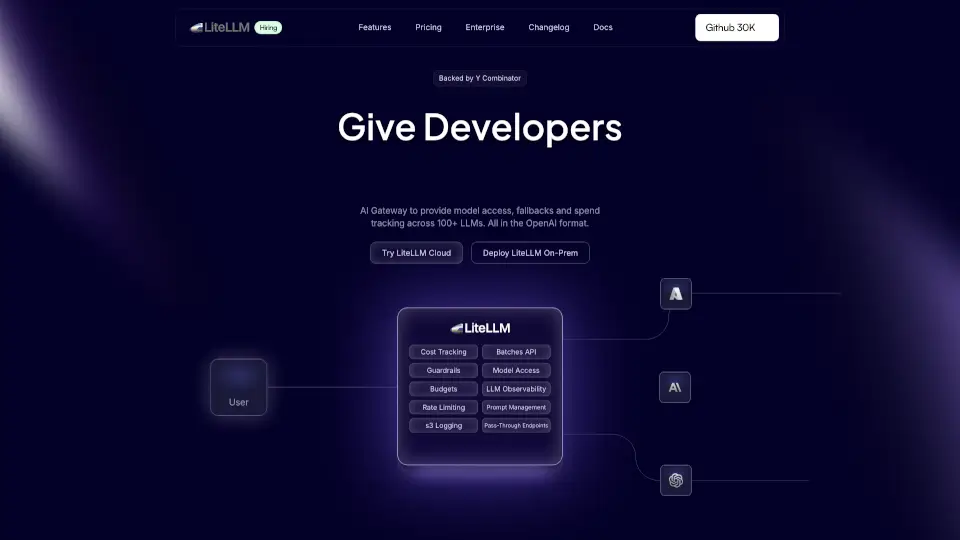

Что такое BerriAI-litellm?

LiteLLM - это мощный Python SDK и прокси-сервер, который позволяет вам взаимодействовать с более чем 100 API LLM в формате OpenAI. Он поддерживает такие платформы, как Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate и Groq.

Какие особенности у BerriAI-litellm?

- Универсальный доступ: Легко вызывайте модели LLM с помощью единого интерфейса.

- Логика повторных попыток: Обеспечивает надежность, автоматически повторяя запросы при сбоях.

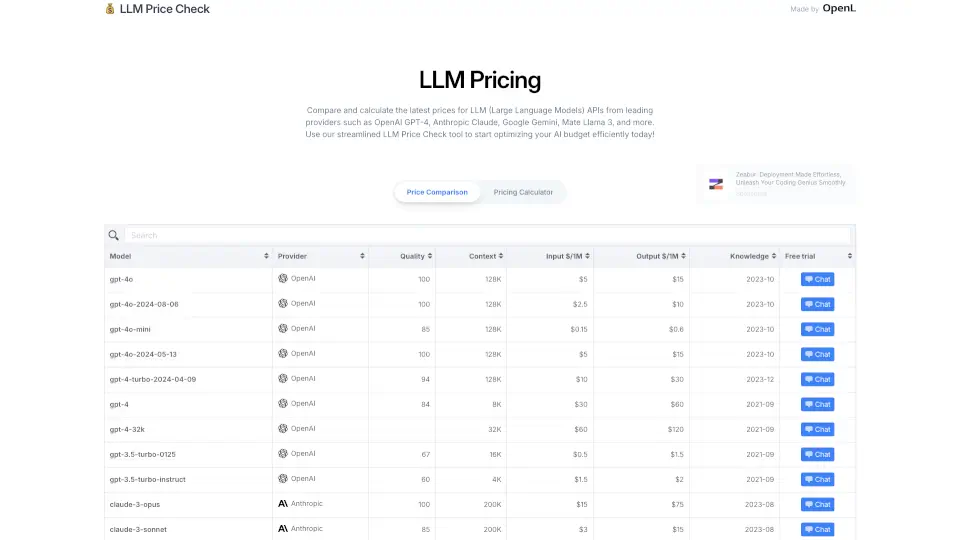

- Отслеживание затрат: Устанавливайте бюджеты и лимиты на использование API для управления расходами.

- Поддержка потоковой передачи: Получайте ответы в реальном времени с помощью потоковой передачи данных.

- Интеграция с инструментами логирования: Легко отправляйте данные в Lunary, MLflow и другие инструменты.

Какие случаи использования BerriAI-litellm?

- Чат-боты: Создавайте интерактивные чат-боты, которые могут общаться с пользователями.

- Генерация контента: Используйте LLM для создания статей, рассказов и других текстов.

- Анализ данных: Применяйте модели для обработки и анализа больших объемов текстовой информации.

Как использовать BerriAI-litellm?

- Установите LiteLLM с помощью команды

pip install litellm. - Настройте переменные окружения для API-ключей.

- Используйте функции SDK для вызова моделей LLM, например:

from litellm import completion response = completion(model="openai/gpt-4o", messages=[{"role": "user", "content": "Привет!"}]) print(response)