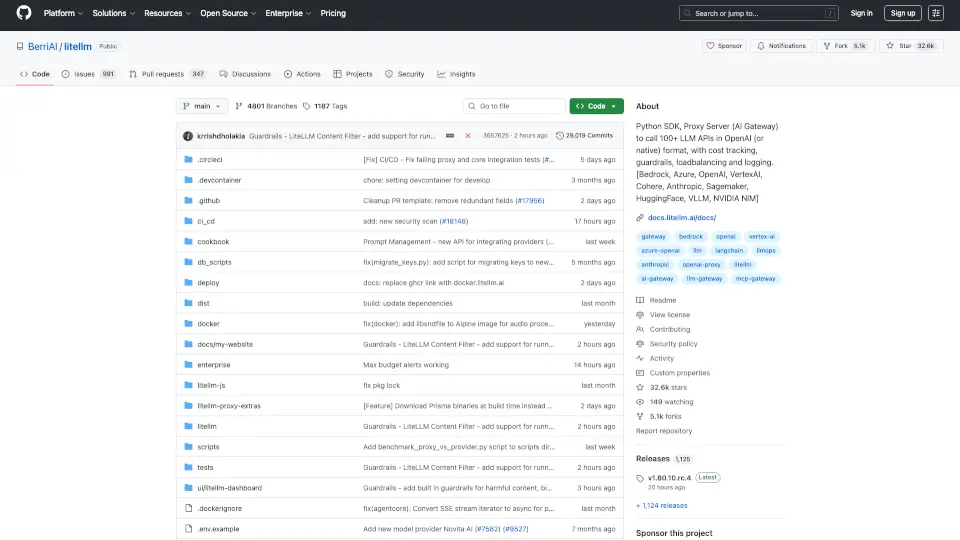

O que é BerriAI-litellm?

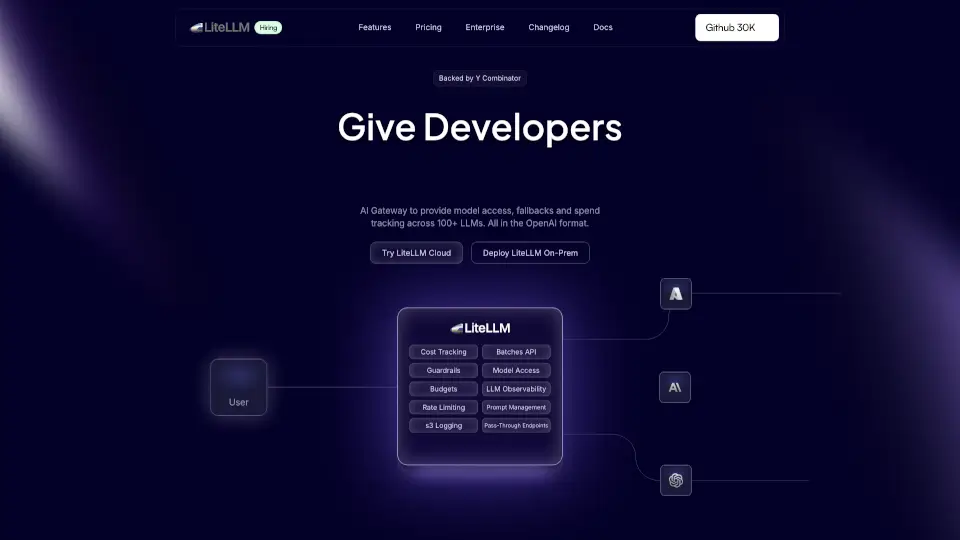

O LiteLLM é uma poderosa ferramenta que funciona como um SDK Python e um servidor proxy. Ele permite que você chame mais de 100 APIs de LLM (Modelos de Linguagem Grande) em um formato compatível com a OpenAI. Com suporte para provedores como Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate e Groq, o LiteLLM simplifica a integração de diferentes modelos de linguagem em seus projetos.

Quais são as características de BerriAI-litellm?

- Integração Simples: Conecte-se facilmente a várias APIs de LLM com um único SDK.

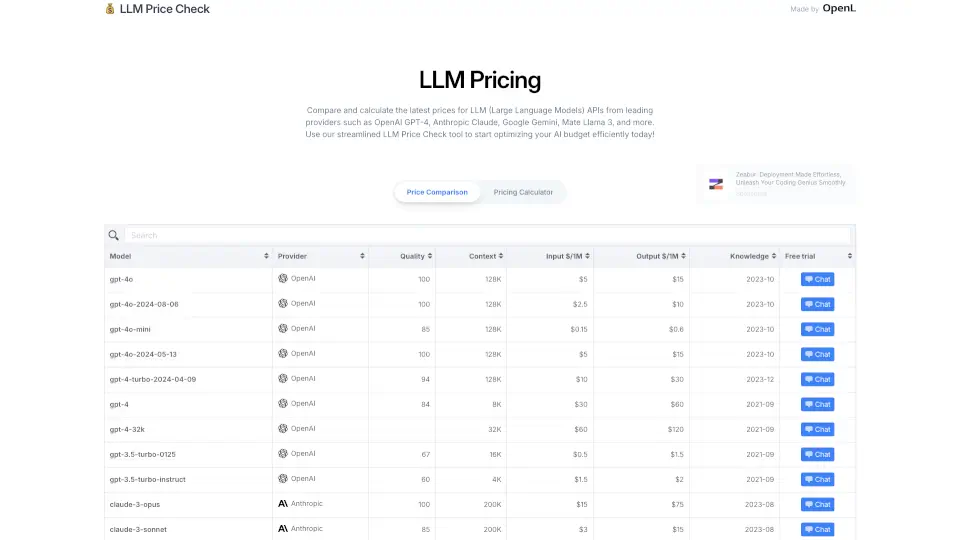

- Gerenciamento de Custos: Monitore gastos e defina limites de taxa por projeto e chave de API.

- Suporte a Streaming: Receba respostas em tempo real com suporte a streaming para todos os modelos.

- Callbacks para Logging: Envie dados para ferramentas como Lunary, MLflow e Slack para monitoramento e análise.

- Proxy Server: Um servidor proxy que facilita a comunicação com diferentes provedores de LLM.

Quais são os casos de uso de BerriAI-litellm?

- Desenvolvimento de Chatbots: Crie chatbots inteligentes que podem interagir com os usuários de forma natural.

- Geração de Conteúdo: Utilize modelos de linguagem para gerar textos, artigos e muito mais.

- Análise de Sentimentos: Implemente análises de sentimentos em feedbacks de clientes ou redes sociais.

- Tradução Automática: Use o LiteLLM para traduzir textos entre diferentes idiomas de forma eficiente.

Como usar BerriAI-litellm?

- Instale o LiteLLM com o comando

pip install litellm. - Configure suas chaves de API no arquivo

.env. - Inicie o servidor proxy com

litellm --model huggingface/bigcode/starcoder. - Faça chamadas para o modelo usando o SDK, como mostrado nos exemplos de uso.