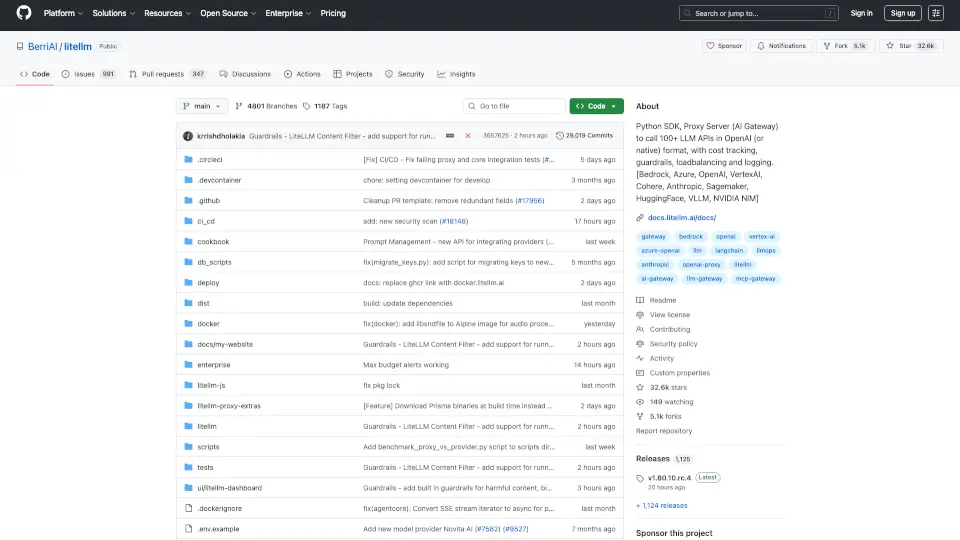

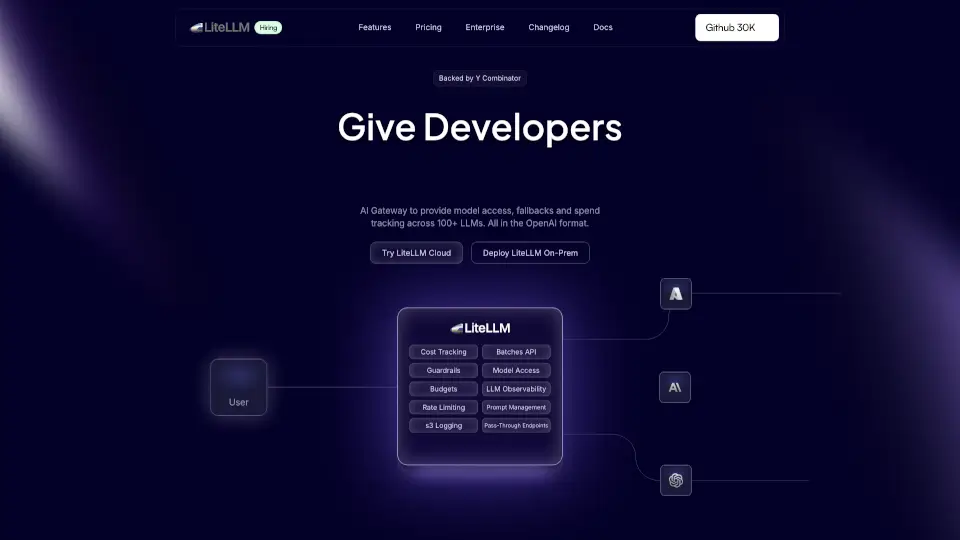

¿Qué es BerriAI-litellm?

LiteLLM es un SDK de Python y un servidor proxy que te permite acceder a más de 100 APIs de modelos de lenguaje (LLM) en un formato compatible con OpenAI. Con LiteLLM, puedes interactuar fácilmente con proveedores como Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate y Groq.

¿Cuáles son las características de BerriAI-litellm?

- Interfaz Unificada: Llama a diferentes modelos de lenguaje usando un formato estándar.

- Manejo de Errores: Implementa lógica de reintentos y fallback para asegurar respuestas consistentes.

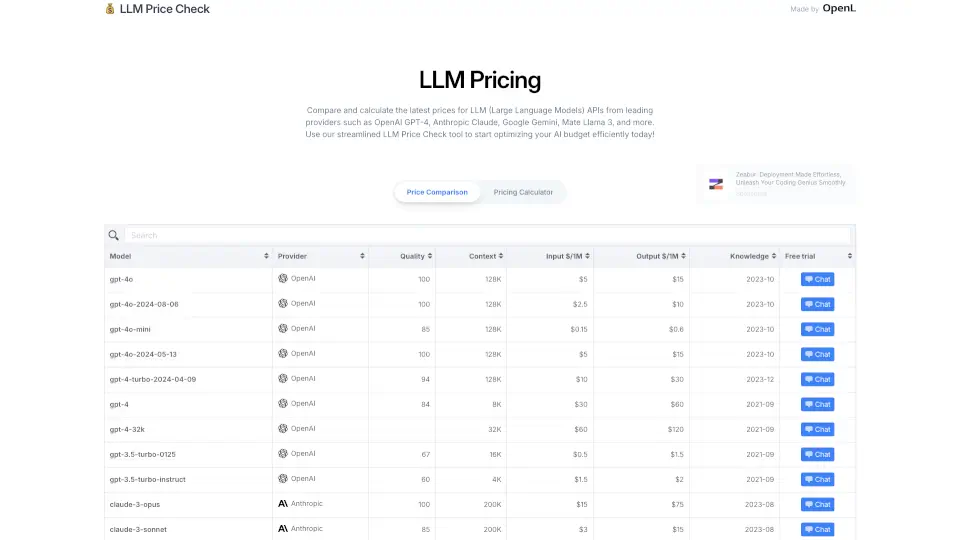

- Control de Costos: Establece presupuestos y límites de tasa por proyecto y clave API.

- Soporte para Streaming: Recibe respuestas en tiempo real de los modelos.

- Integración de Herramientas de Registro: Envía datos a plataformas como MLflow, DynamoDB y más.

¿Cuáles son los casos de uso de BerriAI-litellm?

- Desarrollo de Aplicaciones: Integra modelos de lenguaje en tus aplicaciones para mejorar la interacción con los usuarios.

- Análisis de Datos: Utiliza modelos para procesar y analizar grandes volúmenes de texto.

- Automatización de Tareas: Crea bots que pueden responder preguntas o realizar tareas automáticamente.

¿Cómo usar BerriAI-litellm?

- Instalación: Ejecuta

pip install litellmpara instalar el SDK. - Configuración: Establece las variables de entorno necesarias, como las claves API.

- Realiza Llamadas: Usa el método

completionpara interactuar con los modelos de lenguaje.