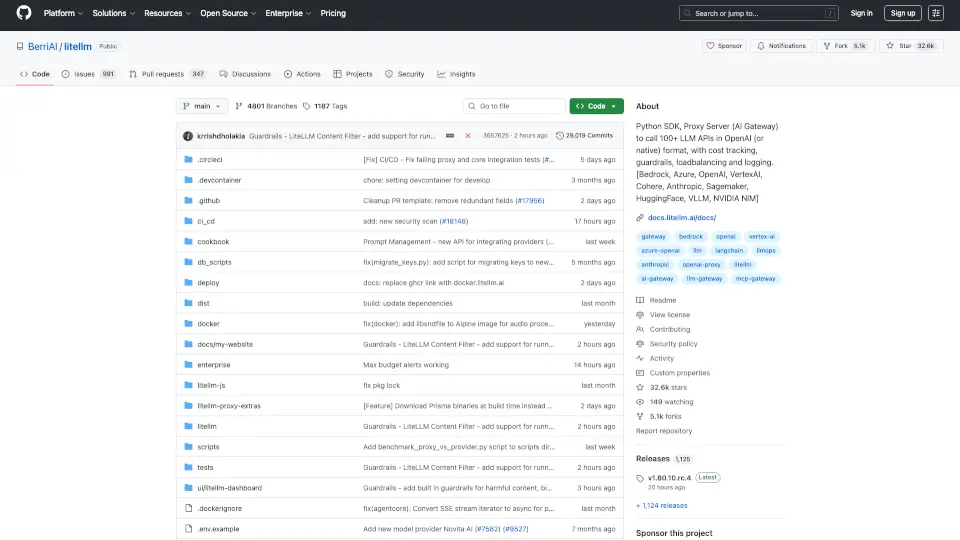

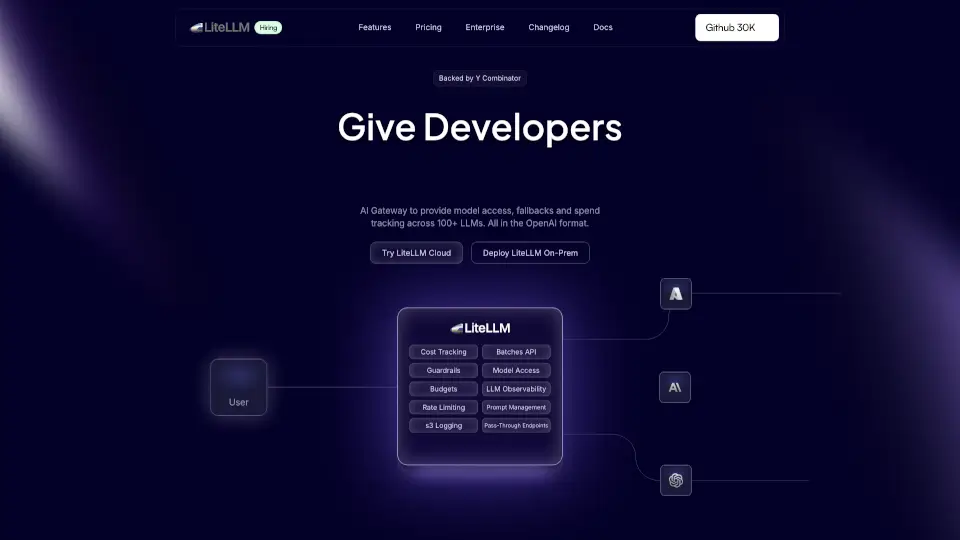

BerriAI-litellmとは何ですか?

LiteLLMは、OpenAI形式で100以上のLLM APIを呼び出すためのPython SDKおよびプロキシサーバーです。これにより、さまざまなプロバイダー(Bedrock、Azure、OpenAI、VertexAI、Cohere、Anthropic、Sagemaker、HuggingFace、Replicate、Groqなど)に簡単にアクセスできます。

BerriAI-litellmの特徴は何ですか?

- 多様なプロバイダーサポート: 100以上のLLM APIをサポート。

- 一貫した出力: 応答は常に同じ形式で提供されます。

- リトライ/フォールバックロジック: 複数のデプロイメント間でのリトライ機能。

- 予算設定とレート制限: プロジェクトごとに予算とレート制限を設定可能。

- ストリーミングサポート: モデルの応答をストリーミングで受け取ることができます。

BerriAI-litellmの使用例は何ですか?

- チャットボットの構築: ユーザーとの対話をスムーズに行うためのチャットボット。

- データ分析: 大量のデータを処理し、洞察を得るためのツール。

- コンテンツ生成: 自動的にテキストを生成するアプリケーション。

BerriAI-litellmの使い方は?

- 環境変数の設定: APIキーを環境変数に設定します。

- モデルの呼び出し:

completion関数を使用してモデルを呼び出します。 - 応答の処理: 受け取った応答を適切に処理します。