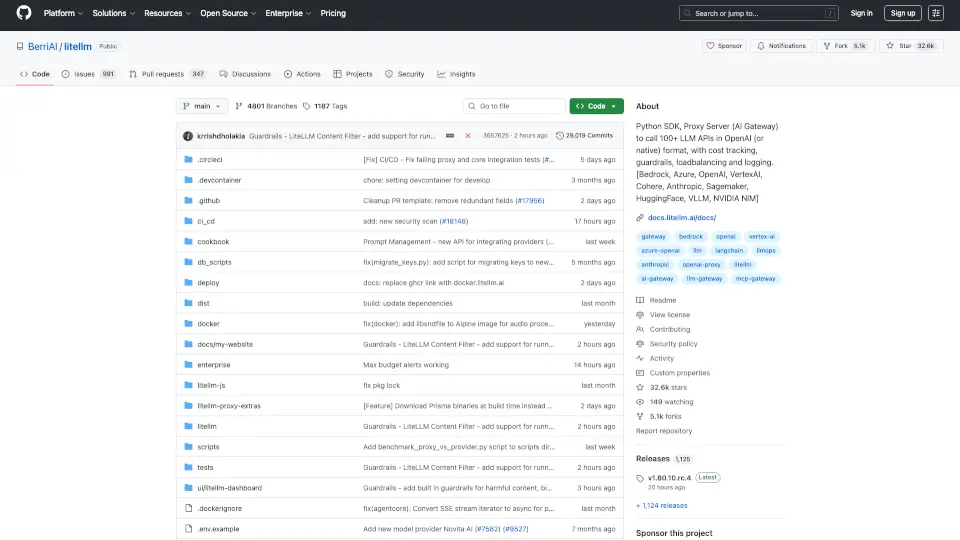

Was ist BerriAI-litellm?

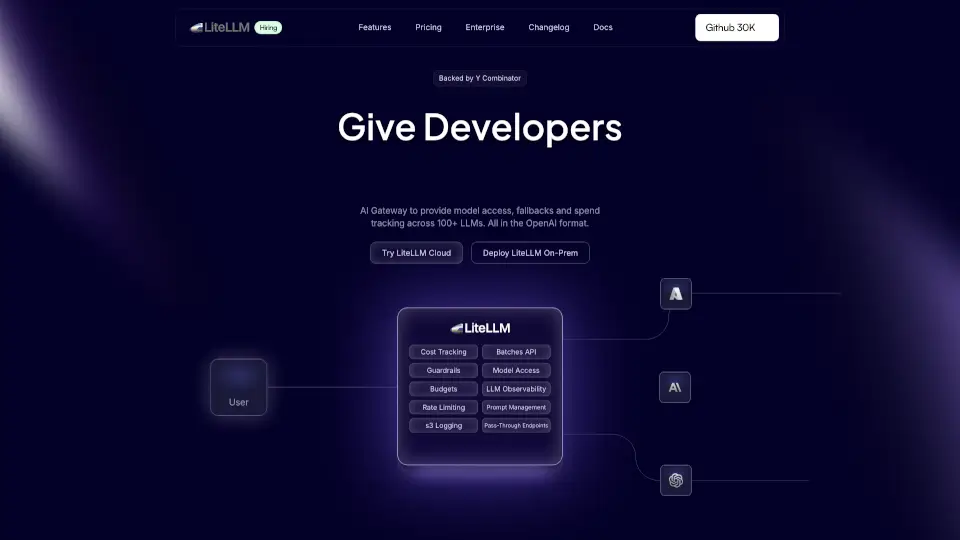

LiteLLM ist ein leistungsstarkes Python SDK und Proxy-Server, der es dir ermöglicht, über 100 LLM-APIs im OpenAI-Format zu nutzen. Egal, ob du mit Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate oder Groq arbeitest, LiteLLM macht es einfach, diese Technologien zu integrieren.

Was sind die Merkmale von BerriAI-litellm?

- Vielseitige API-Unterstützung: Nutze über 100 LLM-APIs in einem einheitlichen Format.

- Einfache Integration: Leicht zu implementieren in bestehende Projekte.

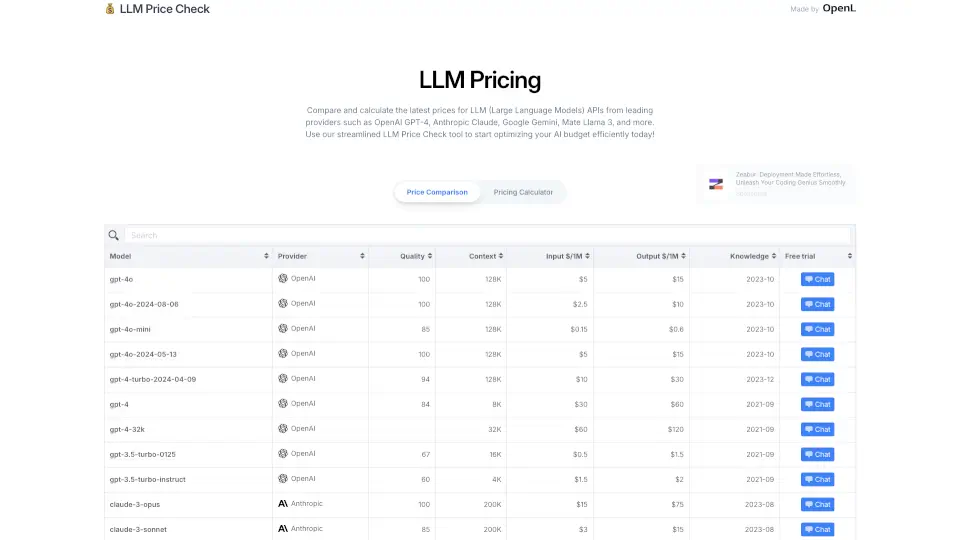

- Kostentracking: Behalte deine Ausgaben im Blick und setze Budgets für verschiedene Projekte.

- Retry-Logik: Automatisches Fallback bei API-Fehlern.

- Streaming-Unterstützung: Erhalte Antworten in Echtzeit.

Was sind die Anwendungsfälle von BerriAI-litellm?

- Chatbots: Erstelle interaktive Chatbots, die mit Nutzern in natürlicher Sprache kommunizieren.

- Inhaltsgenerierung: Generiere Texte, Gedichte oder Geschichten mit KI-Unterstützung.

- Datenanalyse: Nutze LLMs zur Analyse und Verarbeitung von großen Datenmengen.

- Bildgenerierung: Erstelle Bilder basierend auf Textbeschreibungen.

Wie benutzt man BerriAI-litellm?

- Installiere LiteLLM mit

pip install litellm. - Setze deine API-Schlüssel in den Umgebungsvariablen.

- Verwende die

completion-Funktion, um Anfragen an die gewünschten Modelle zu senden. - Nutze die Streaming-Funktion für Echtzeit-Antworten.