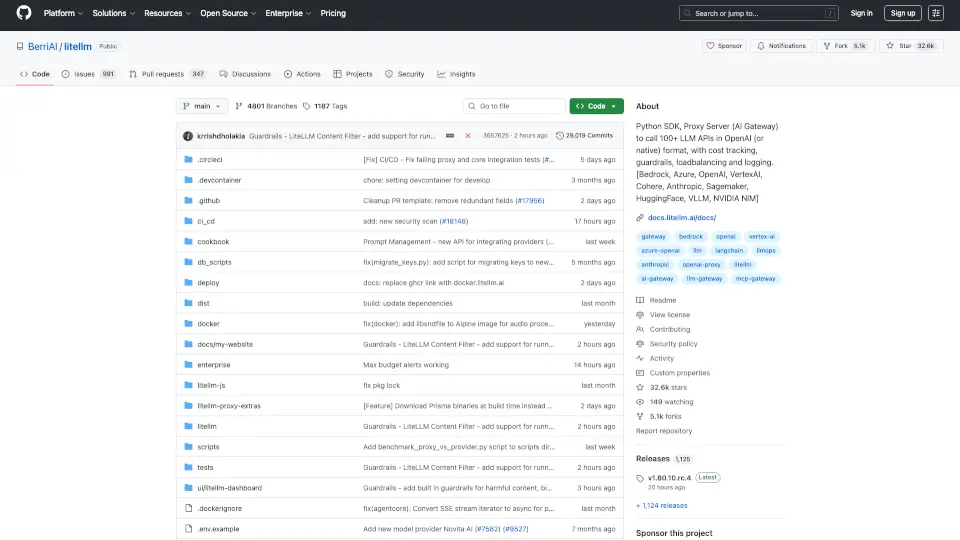

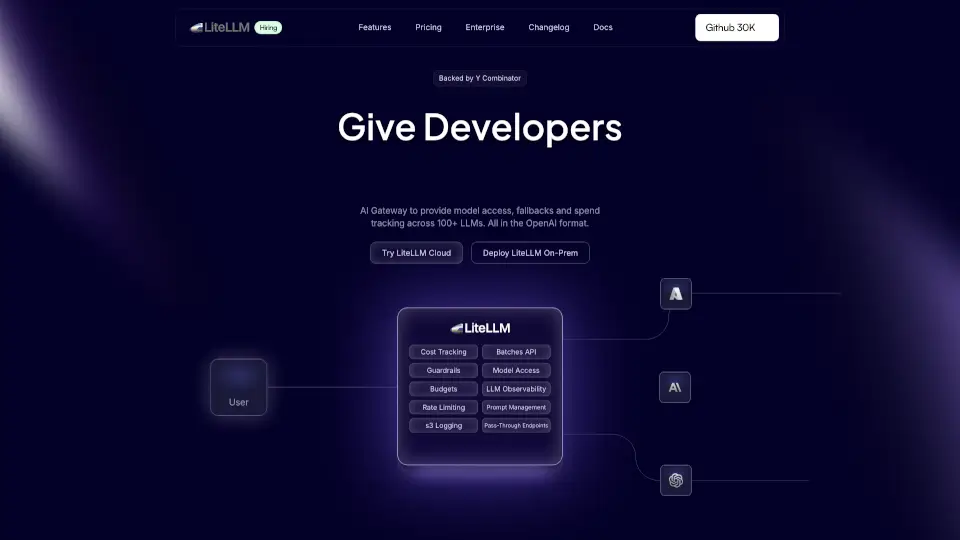

Qu'est-ce que BerriAI-litellm ?

Découvrez LiteLLM, un SDK Python et un serveur proxy qui vous permet d'accéder à plus de 100 API LLM au format OpenAI. Que vous utilisiez Bedrock, Azure, OpenAI, VertexAI, Cohere, Anthropic, Sagemaker, HuggingFace, Replicate, ou Groq, LiteLLM simplifie vos appels API.

Quelles sont les caractéristiques de BerriAI-litellm ?

- Accès à de nombreux modèles: Utilisez facilement des modèles de différents fournisseurs.

- Gestion des erreurs: LiteLLM inclut une logique de reprise pour garantir des réponses fiables.

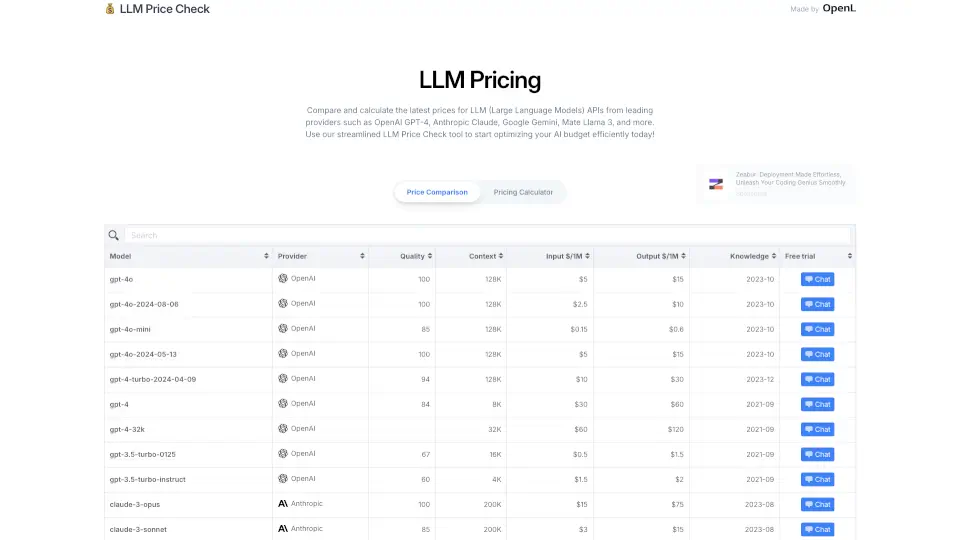

- Suivi des coûts: Gardez un œil sur vos dépenses et définissez des limites par projet.

- Interface conviviale: Profitez d'une interface simple pour gérer vos appels API.

Quels sont les cas d'utilisation de BerriAI-litellm ?

- Développement d'applications: Intégrez des modèles LLM dans vos applications sans tracas.

- Prototypage rapide: Testez différentes API LLM pour trouver celle qui convient le mieux à vos besoins.

- Analyse de données: Utilisez des modèles pour traiter et analyser des données textuelles.

Comment utiliser BerriAI-litellm ?

- Installez LiteLLM avec

pip install litellm. - Configurez vos clés API dans les variables d'environnement.

- Utilisez le SDK pour faire des appels API en toute simplicité.