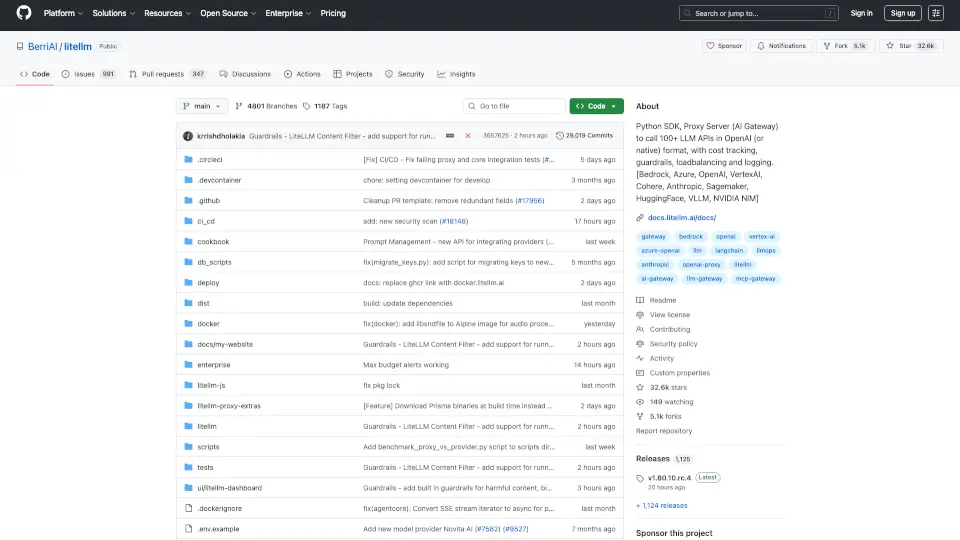

什么是BerriAI-litellm?

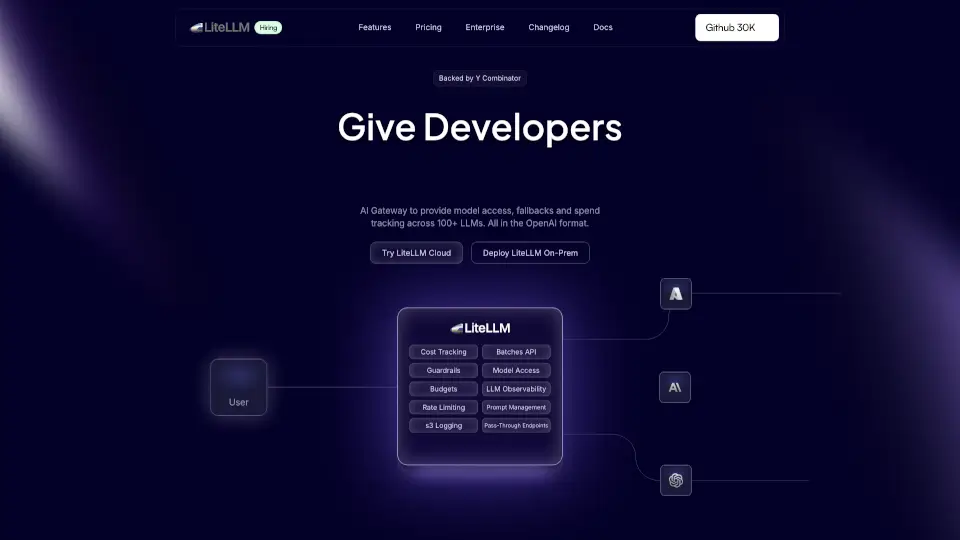

LiteLLM 是一个强大的 Python SDK 和代理服务器,旨在通过 OpenAI 格式调用 100 多个 LLM API,包括 Bedrock、Azure、OpenAI、VertexAI、Cohere、Anthropic、Sagemaker、HuggingFace、Replicate 和 Groq。它简化了与不同 LLM 提供商的交互,让开发者可以轻松集成和使用各种语言模型。

BerriAI-litellm的核心功能有哪些?

- 多模型支持: 支持多种 LLM 提供商,用户可以根据需求选择合适的模型。

- 统一接口: 所有 API 调用都遵循 OpenAI 格式,简化了开发过程。

- 重试和回退机制: 在多个部署之间自动处理重试和回退,确保稳定性。

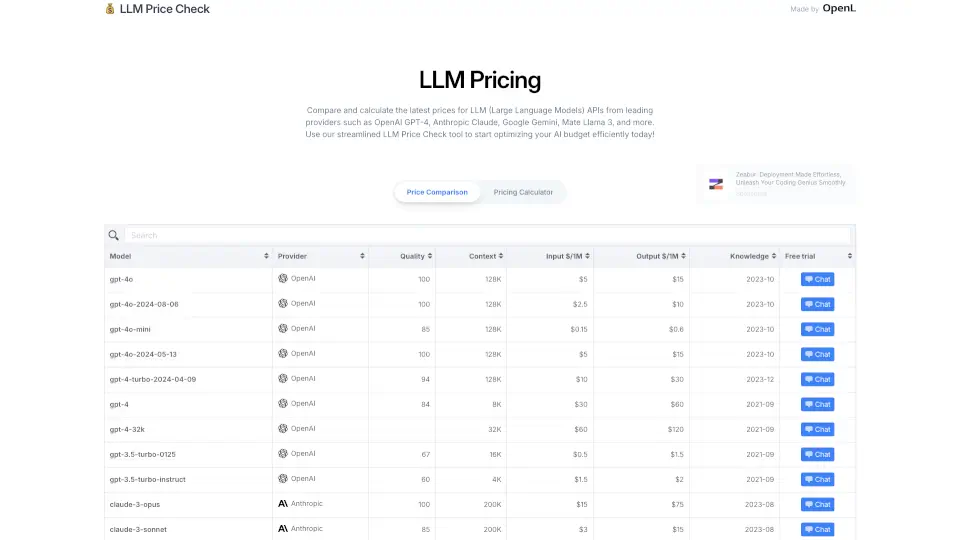

- 预算和速率限制: 用户可以为每个项目和 API 密钥设置预算和速率限制,便于管理成本。

- 流式响应: 支持流式传输模型响应,实时获取结果。

BerriAI-litellm的使用案例有哪些?

- 聊天机器人: 利用 LiteLLM 构建智能聊天机器人,提供自然语言交互。

- 内容生成: 自动生成文章、诗歌或其他文本内容,提升创作效率。

- 数据分析: 使用 LLM 进行数据分析和报告生成,帮助企业做出更明智的决策。

- 教育工具: 开发教育应用,利用 LLM 提供个性化学习体验。

如何使用BerriAI-litellm?

- 安装 LiteLLM: 使用

pip install litellm命令安装。 - 设置环境变量: 配置 API 密钥以便进行调用。

- 调用模型: 使用

completion函数进行 API 调用,传入所需的消息和模型名称。 - 处理响应: 根据返回的结果进行后续处理。