什麼是QwQ-32B?

Qwen/QwQ-32B 是一款先進的推理模型,專為文本生成而設計。它在解決複雜問題方面表現出色,能夠與最先進的模型競爭。

QwQ-32B的特色是什麼?

- 模型類型: 因果語言模型

- 參數數量: 32.5B

- 層數: 64

- 注意力頭數: 40(Q)和8(KV)

- 上下文長度: 支持高達131,072個標記

QwQ-32B的使用案例有哪些?

- 文本生成: 用於創建對話、故事或其他文本內容。

- 數學問題解決: 能夠逐步推理並提供最終答案。

- 多選題回答: 標準化回答格式,便於評估。

如何使用QwQ-32B?

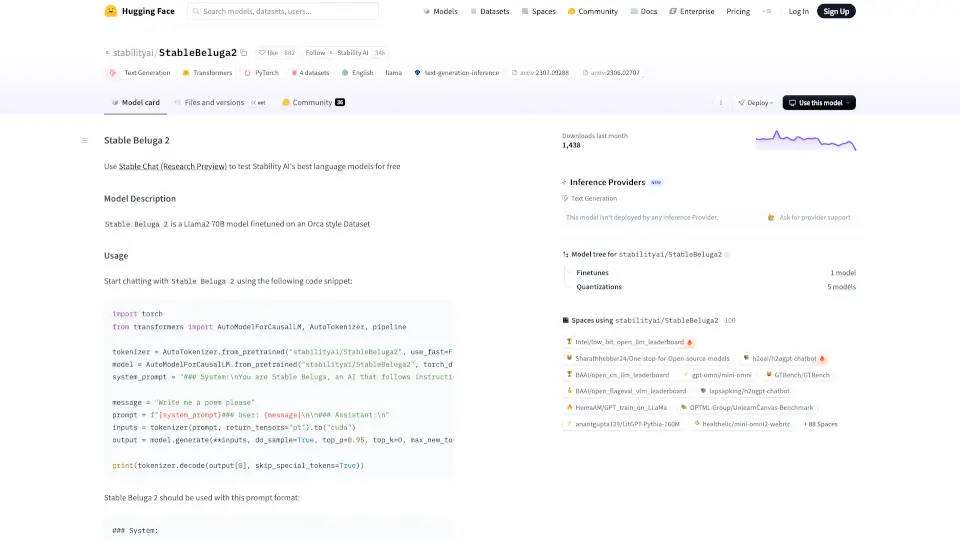

- 使用最新版本的 transformers 庫。

- 加載模型和標記器:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "Qwen/QwQ-32B" model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto") tokenizer = AutoTokenizer.from_pretrained(model_name) - 準備提示並生成文本:

prompt = "如何計算單詞 \"strawberry\" 中的 r 的數量" messages = [{"role": "user", "content": prompt}] text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True) model_inputs = tokenizer([text], return_tensors="pt").to(model.device) generated_ids = model.generate(**model_inputs, max_new_tokens=32768) response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0] print(response)