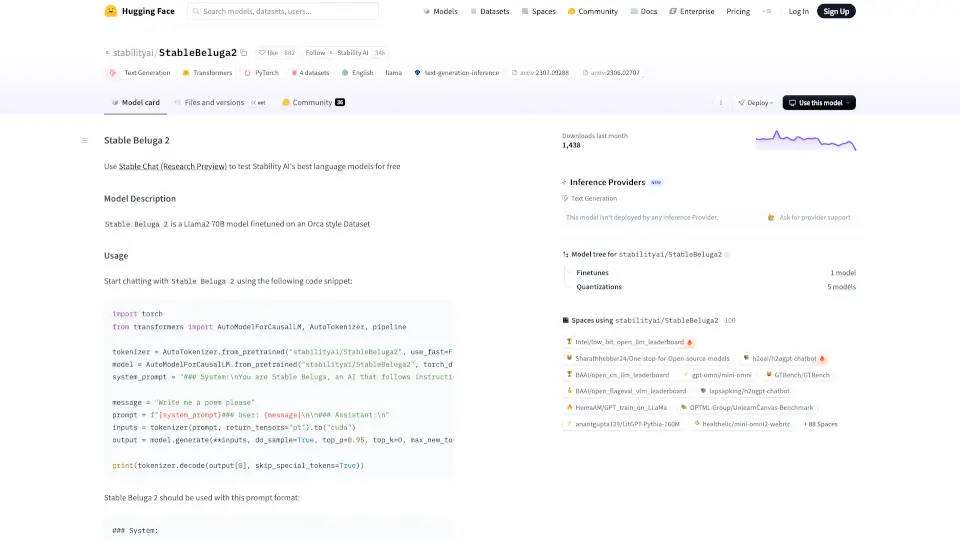

什么是StableBeluga2?

Stable Beluga 2 是由 Stability AI 开发的一款基于 Llama2 70B 模型的高级语言模型,专为文本生成任务设计。它通过 Orca 风格的数据集进行微调,能够提供高质量的对话和文本生成服务。

StableBeluga2的核心功能有哪些?

- 强大的文本生成能力:基于 Llama2 70B 模型,能够生成流畅、连贯的文本。

- 高效的推理性能:支持混合精度计算(BF16),优化了内存使用和计算速度。

- 灵活的提示格式:使用特定的系统提示格式,确保模型输出符合预期。

- 多语言支持:虽然主要针对英语,但模型可以处理多种语言的文本生成任务。

StableBeluga2的使用案例有哪些?

- 智能对话助手:用于客户服务、虚拟助手等场景,提供自然流畅的对话体验。

- 内容创作:帮助作家、博主等生成创意文本、诗歌、故事等。

- 教育辅助:为学生和教师提供学习材料生成、问题解答等服务。

如何使用StableBeluga2?

- 安装必要的库:

pip install torch transformers - 加载模型和分词器:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)

model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")

- 使用系统提示格式进行对话:

system_prompt = "### System:

You are Stable Beluga, an AI that follows instructions extremely well. Help as much as you can. Remember, be safe, and don't do anything illegal.

"

message = "Write me a poem please"

prompt = f"{system_prompt}### User: {message}

### Assistant:

"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, do_sample=True, top_p=0.95, top_k=0, max_new_tokens=256)

print(tokenizer.decode(output[0], skip_special_tokens=True))