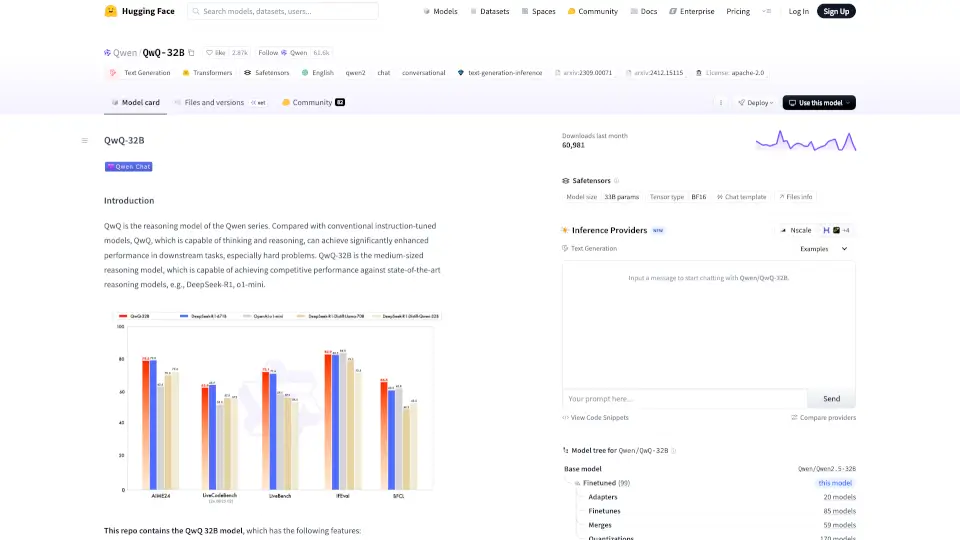

¿Qué es QwQ-32B?

Qwen/QwQ-32B es un modelo de lenguaje de última generación diseñado para mejorar la inteligencia artificial a través de la razonación. Este modelo es parte de la serie Qwen y se destaca por su capacidad para resolver problemas complejos de manera efectiva.

¿Cuáles son las características de QwQ-32B?

- Modelo de Lenguaje Causal: QwQ-32B utiliza una arquitectura avanzada de transformers.

- Parámetros: Cuenta con 32.5 mil millones de parámetros, lo que le permite manejar tareas complejas.

- Capacidad de Contexto: Puede procesar hasta 131,072 tokens, ideal para entradas largas.

- Entrenamiento Avanzado: Combina preentrenamiento y ajuste fino supervisado, mejorando su rendimiento en tareas específicas.

¿Cuáles son los casos de uso de QwQ-32B?

- Generación de Texto: Ideal para crear contenido conversacional y responder preguntas.

- Resolución de Problemas: Útil en aplicaciones que requieren razonamiento lógico y matemático.

- Interacción en Chatbots: Mejora la experiencia del usuario en aplicaciones de chat.

¿Cómo usar QwQ-32B?

Para utilizar Qwen/QwQ-32B, primero carga el modelo y el tokenizador. Luego, prepara tu mensaje y genera la respuesta utilizando el modelo. Asegúrate de seguir las pautas de uso para obtener el mejor rendimiento.