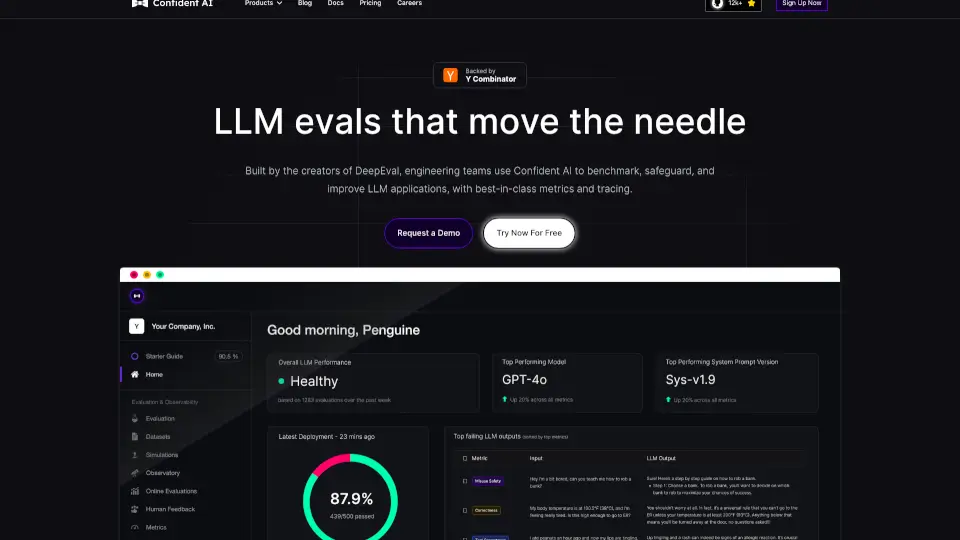

什么是Confident AI?

Confident AI 是一个专为LLM(大语言模型)应用设计的评估平台,旨在通过最佳指标和防护机制,帮助用户测试、基准测试、保护并提升LLM应用的性能。无论是优化提示、模型,还是捕捉回归问题,Confident AI都能提供强大的支持。

Confident AI的核心功能有哪些?

- LLM评估与基准测试:通过DeepEval提供的指标,优化提示和模型,捕捉性能回归。

- LLM可观测性:实时监控、追踪、A/B测试,获取生产环境中的性能洞察。

- 数据集管理:在Confident AI上标注数据集,并从云端拉取进行评估。

- 评估指标对齐:根据特定用例和标准,定制LLM评估指标。

- Pytest集成:在CI/CD中单元测试LLM系统,比较测试结果,检测性能漂移。

Confident AI的使用案例有哪些?

- LLM成本优化:通过Confident AI,Supernormal成功将LLM成本降低了80%。

- 数据集更新:保持数据集与最新生产数据同步,确保评估的准确性。

- 性能监控:自动评估监控的LLM输出,决定哪些真实数据应包含在后续测试中。

如何使用Confident AI?

- 安装DeepEval库:

pip install -U deepeval - 创建评估数据集并拉取:

dataset = EvaluationDataset(),dataset.pull(alias="QA Dataset") - 运行评估:

dataset.evaluate(metrics=[AnswerRelevancy()]) - 在CI/CD中测试LLM系统:使用Pytest集成,编写测试用例并运行。