Was ist Berri?

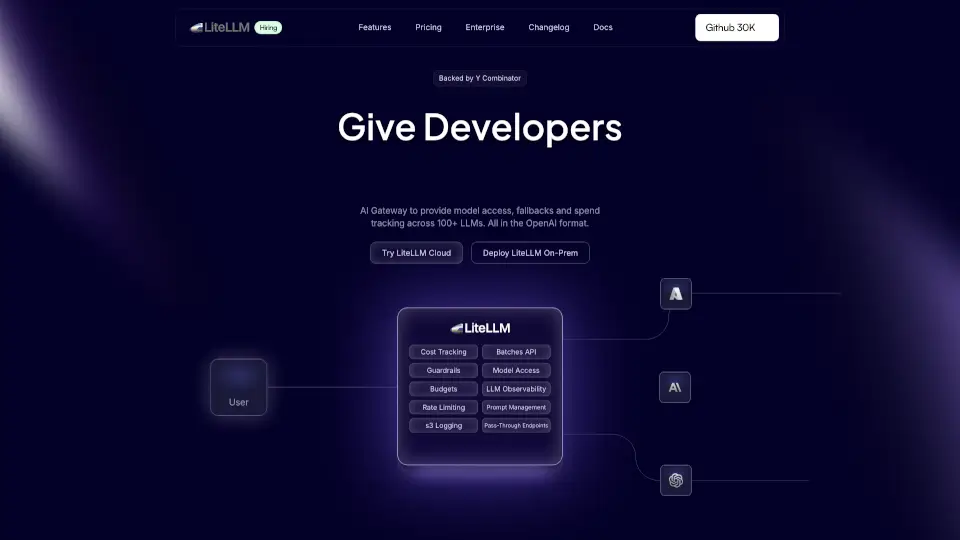

LiteLLM ist dein All-in-One-Tool für den Zugriff auf über 100+ LLMs (Large Language Models) wie OpenAI, Azure, Gemini und Bedrock. Es vereinfacht das Loadbalancing, Fallbacks und die Kostenverfolgung – alles im OpenAI-Format. Egal, ob du Entwickler, Unternehmen oder einfach nur neugierig bist, LiteLLM macht den Zugriff auf KI-Modelle kinderleicht.

Was sind die Merkmale von Berri?

- Modellzugriff: Kontrolliere den Zugriff auf Modelle über virtuelle Schlüssel, Teams und Zugriffsgruppen.

- Kostenverfolgung: Verfolge Ausgaben und setze Budgetlimits für Modelle, Schlüssel und Teams.

- Logging: Protokolliere Anfragen, Antworten und Nutzungsdaten in S3, Datadog, OTEL und mehr.

- Pass-through-Endpunkte: Migriere Projekte einfach mit integrierter Kostenverfolgung und Protokollierung.

- OpenAI-kompatible API: Nutze über 100+ LLMs im OpenAI-Format.

- Self-serve-Portal: Teams können ihre eigenen Schlüssel verwalten.

Was sind die Anwendungsfälle von Berri?

- KI-Entwicklung: Schneller Zugriff auf verschiedene LLMs für Entwickler.

- Unternehmen: Kostenkontrolle und Zugriffsmanagement für Teams.

- Protokollierung: Einfache Integration mit Logging-Tools wie Langfuse und OTEL.

Wie benutzt man Berri?

- Installation: Installiere LiteLLM über Docker oder das Python SDK.

- Konfiguration: Richte virtuelle Schlüssel und Budgetlimits ein.

- Integration: Nutze die OpenAI-kompatible API für deine Projekte.

- Protokollierung: Integriere Logging-Tools für detaillierte Analysen.