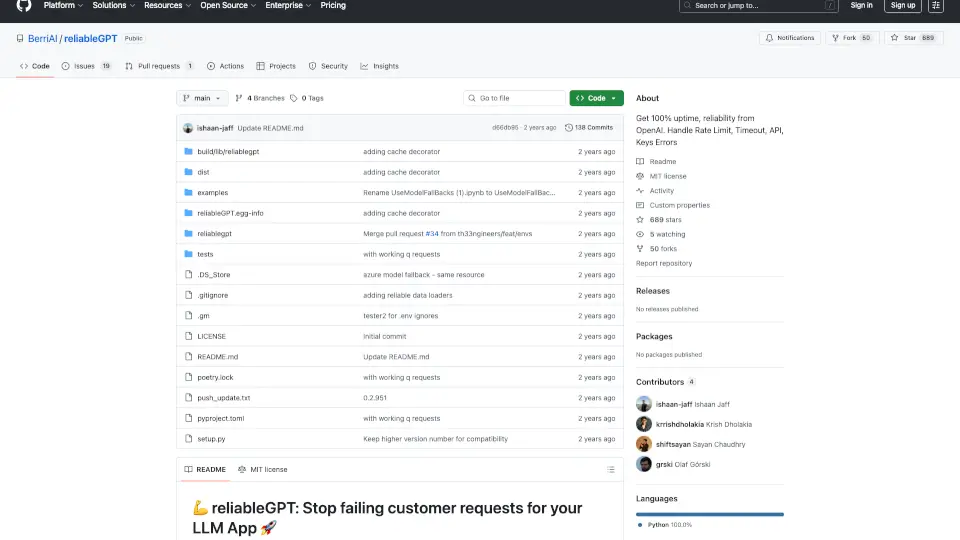

¿Qué es Berri?

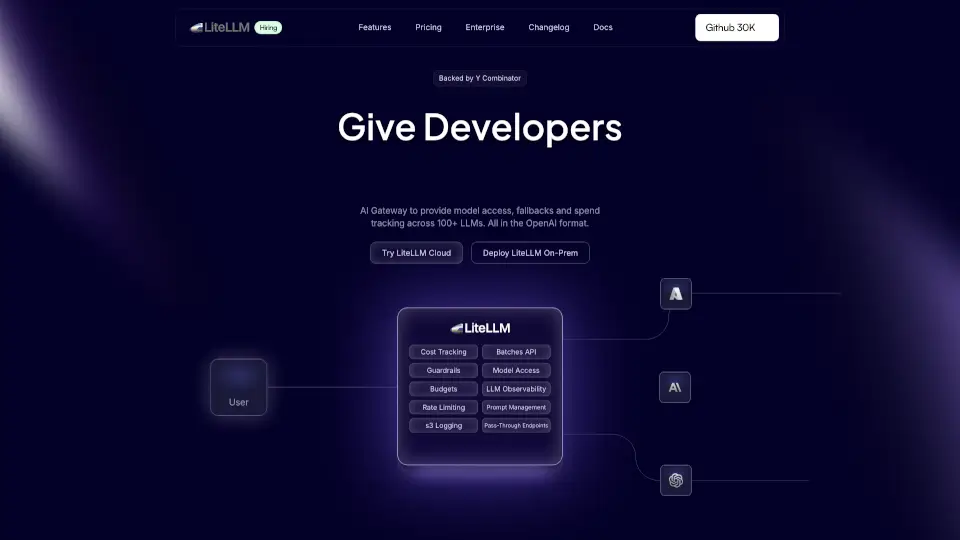

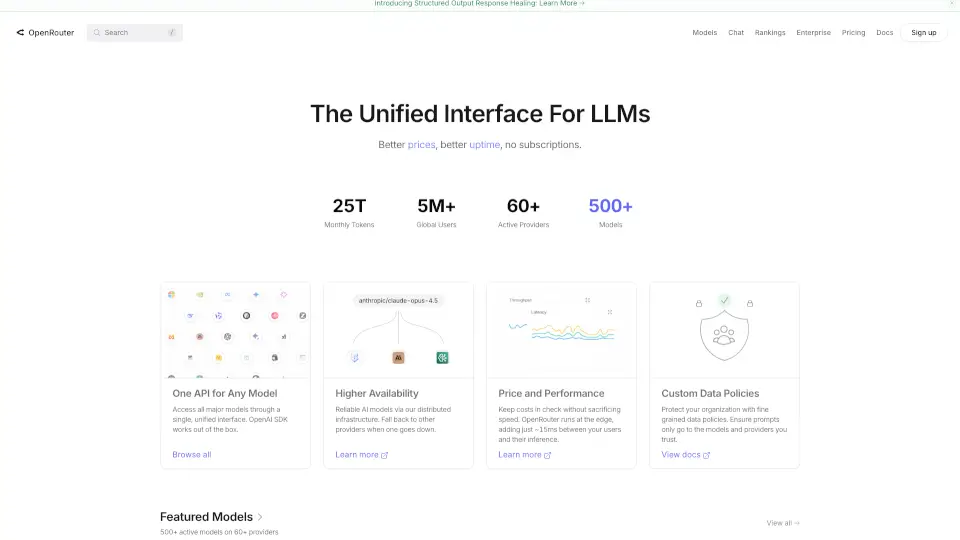

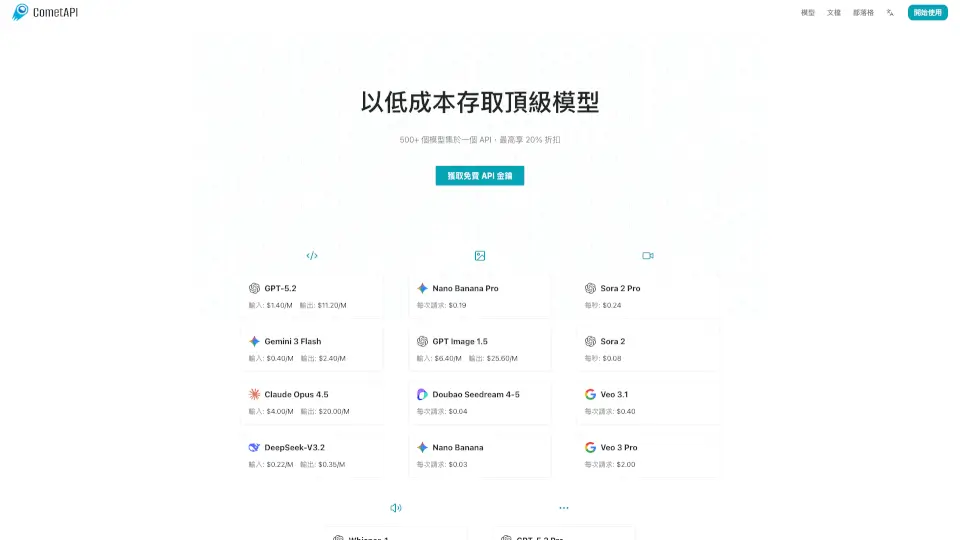

LiteLLM es tu puerta de entrada para acceder a más de 100 modelos de lenguaje (LLMs) de manera sencilla y eficiente. Con un formato compatible con OpenAI, LiteLLM te permite gestionar el acceso, el seguimiento de gastos y los respaldos de modelos de forma centralizada. Ya sea que trabajes con Azure, Gemini, Bedrock u OpenAI, LiteLLM simplifica todo el proceso.

¿Cuáles son las características de Berri?

- Acceso a 100+ LLMs: Compatible con el formato OpenAI, incluyendo /chat/completion y /embedding.

- Seguimiento de gastos: Controla y limita el presupuesto en modelos, claves y equipos.

- Claves virtuales: Gestiona el acceso a modelos mediante claves virtuales y grupos de acceso.

- Balanceo de carga: Optimiza el rendimiento con límites de RPM/TPM y respaldos automáticos.

- Portal autogestionado: Permite que los equipos gestionen sus propias claves en producción.

¿Cuáles son los casos de uso de Berri?

- Migración de proyectos a endpoints de paso con seguimiento de gastos integrado.

- Gestión centralizada de acceso a múltiples proveedores de LLMs.

- Monitoreo de uso y gastos en tiempo real para equipos y proyectos.

¿Cómo usar Berri?

- Instala LiteLLM usando Docker o el SDK de Python.

- Configura tus claves virtuales y grupos de acceso.

- Utiliza los endpoints compatibles con OpenAI para acceder a los modelos.

- Monitorea el gasto y el rendimiento desde el portal autogestionado.